Veröffentlicht 26. Juni 2025

von Timo Hinrichsen

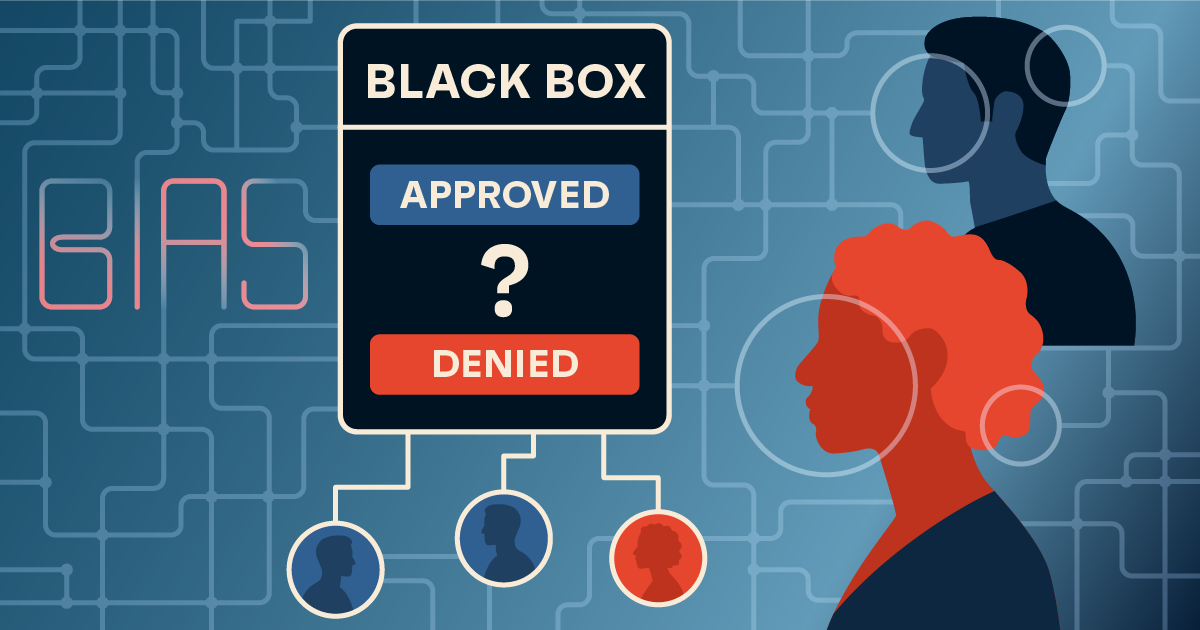

Wenn Maschinen diskriminieren: Wie KI-Systeme Vorurteile verstärken können

Die rasante Entwicklung Künstlicher Intelligenz (KI) eröffnet vielfältige neue Möglichkeiten – von effizienteren Arbeitsprozessen bis hin zu personalisierten Services. Doch je breiter der Einsatzbereich, desto lauter werden auch die kritischen Stimmen. Eine der schwerwiegendsten Herausforderungen: algorithmische Diskriminierung.

Algorithmische Diskriminierung: Wenn Daten nicht neutral sind

KI-Systeme basieren auf Daten – oft in gewaltigem Umfang. Doch diese Daten sind keineswegs immer objektiv oder neutral. Sie spiegeln gesellschaftliche Ungleichheiten wider, die – wenn unbeachtet – von der KI nicht nur übernommen, sondern sogar verstärkt werden können. Die Folge: Entscheidungen, die eigentlich fair und automatisiert wirken sollen, führen zu systematischen Benachteiligungen.

Ein eindrückliches Beispiel lieferte das britische Bildungssystem während der Corona-Pandemie. Weil Abschlussprüfungen ausfielen, sollte eine KI die Noten berechnen. Das Ergebnis: Schülerinnen und Schüler aus sozial benachteiligten Regionen wurden systematisch schlechter bewertet. Rund 40 % der Noten mussten korrigiert werden – ein klarer Fall algorithmischer Diskriminierung, der nicht nur für Empörung sorgte, sondern auch gesetzliche Grenzen überschritt.

Wie Diskriminierung durch KI entsteht

Diskriminierung in KI-Systemen kann viele Formen annehmen – und ist oft schwer zu erkennen. Die wichtigsten Typen im Überblick:

- Unmittelbare Diskriminierung: Menschen werden direkt aufgrund geschützter Merkmale wie Herkunft, Geschlecht oder Religion benachteiligt.

- Mittelbare Diskriminierung: Auf den ersten Blick neutrale Kriterien führen indirekt zu Benachteiligung – etwa durch die Bewertung von Teilzeitbeschäftigung, die häufiger Frauen betrifft.

- Statistische Diskriminierung: KI nutzt sogenannte Stellvertreter-Variablen wie den Wohnort, die mit sensiblen Merkmalen korrelieren – und verstärkt so ungewollt bestehende Vorurteile.

- Präferenzbasierte Diskriminierung: Wenn ein System mit Daten trainiert wird, die bestehende gesellschaftliche Vorurteile abbilden – oder sogar die impliziten Vorannahmen der Entwickler widerspiegeln.

Ein weiteres Beispiel: In den USA bewertete ein KI-gestütztes Gesundheitssystem schwarze Patient:innen systematisch niedriger, wenn es um Empfehlungen für bestimmte Behandlungen ging. Der Grund: Der Algorithmus orientierte sich an den bisherigen Gesundheitsausgaben – und ignorierte dabei, dass schwarze Menschen historisch oft schlechter versorgt wurden.

Was hilft gegen algorithmische Diskriminierung?

Der Schlüssel liegt im ethischen Umgang mit Technologie – und zwar von Anfang an. „Ethics by Design“ bedeutet, dass ethische Prinzipien bereits in der Entwicklung berücksichtigt werden. „Ethics of Use“ ergänzt dies durch verantwortungsvollen Umgang im laufenden Betrieb.

Besonders wichtig ist dabei Transparenz: Nur wenn Systeme nachvollziehbar sind, lassen sich Fehlentwicklungen erkennen und korrigieren. Doch gerade bei sogenannten „Black Box“-Modellen wie Deep Learning ist diese Nachvollziehbarkeit eine große Herausforderung.

Um diesem Problem zu begegnen, habe ich einen Referenzprozess in BPMN (Business Process Model and Notation)entwickelt. Er hilft Organisationen dabei, kritische Stellen in der KI-Anwendung zu identifizieren und algorithmische Diskriminierung frühzeitig zu erkennen – bevor daraus strukturelle Probleme oder sogar Rechtsverstöße entstehen.

Fazit: Verantwortung ist kein Add-on

Künstliche Intelligenz darf kein blinder Spiegel gesellschaftlicher Schieflagen sein. Wer mit KI arbeitet, trägt Verantwortung – nicht nur für Funktionalität, sondern auch für Fairness, Nachvollziehbarkeit und gesellschaftliche Wirkung.

Die geplante KI-Verordnung der EU ist ein wichtiger Schritt in Richtung verbindlicher Standards. Doch entscheidend wird sein, wie Unternehmen, Entwickler:innen und Anwender:innen Ethik künftig verstehen: nicht als zusätzliche Last, sondern als Grundbedingung für nachhaltige Innovation.

Dein Experte: Timo Hinrichsen ist Geschäftsführender Gesellschafter und Chief Product Owner bei der team neusta Schweiz AG. Er begleitet seit vielen Jahren Digitalisierungsprojekte in Tourismus, Industrie, Sport und Freizeitwirtschaft. In seiner Arbeit verbindet er technisches Know-how mit UX- und SEO-Expertise und setzt sich für barrierefreie und nutzerzentrierte Lösungen ein. Seine aktuellen Forschungsinteressen liegen im Bereich Künstliche Intelligenz, insbesondere in der Entwicklung von Chat- und Voicebots.

Du willst mehr erfahren?

Timo Hinrichsen freut sich von dir zu hören: t.hinrichsen@neusta.ch